Historique :

Sommaire :

- Présentation

- Le test

- La table de la loi centrée-réduite

- Calcul de la p-valeur exacte si

- Calcul de la p-valeur exacte si

- Tendance pour le rejet de

- Tendance lorsque

- Annexe théorique

- Exemple

- Application sous R

- Application sous SAS

- Bibliographie

Présentation :

Le test binomial, également appelé test exact binomial, a été publié par Ronald Aylmer Fisher en 1925. Il s’agit d’une approche non paramétrique permettant de tester si la répartition des deux groupes d’une variable binaire est aléatoire.

A l’instar du test exact de Fisher, le test binomial est connu comme une alternative au test du de Pearson lorsque la configuration des effectifs ne permet pas son application. Toutefois, lorsque

a plus de deux modalités, c’est bien vers ce dernier (portant également le nom de test multinomial) qu’il convient de se tourner.

Le test :

Hypothèse préliminaire : binaire.

La statistique de test binomial est,

Où est l’effectif du groupe d’intérêt de

et fixé en amont par l’utilisateur,

la probabilité de référence à laquelle on souhaite comparer les proportions observée et

la probabilité associée à la loi Binomiale de paramètres

et de formule,

Deux cas de figure sont à prendre en compte pour le calcul de la p-valeur associée à . Si

alors elle se détermine au travers de l’algorithme de Monte-Carlo et si

alors on calcule le z-score,

, où et

. Le z-score suit une loi normale centrée-réduite.

Que l’on fasse usage de la statistique de test ou

, l’hypothèse

reste :

Il n’y a pas de différence entre les fréquences observées et attendues /

En restant sur le cas le plus fréquent et en lien avec des échantillons en général de grande taille, on pose la valeur seuil de la distribution de la statistique de test

pour une confiance

, et associée à une loi normale centrée-réduite, les hypothèses alternatives sont alors,

– , soit

, pour un test unilatéral à droite ;

– , soit

, pour un test unilatéral à gauche ;

– , soit

, pour un test bilatéral.

La table de la loi normale centrée-réduite

Calcul de la p-valeur exacte si

– Calculer , la proportion attendue au sein de l’effectif.

– Si alors

.

– Sinon, on pose et,

- Si

alors calculer

sur

et la p-valeur de forme :

- Si

alors calculer

sur

et la p-valeur de forme :

On a défini là la version bilatéral du test. Pour passer sur une version unilatéral à droite il faut se contenter d’utiliser le terme de gauche, tandis que pour celle forme à gauche ce sera celui de droite.

Calcul de la p-valeur exacte si

La loi à laquelle reporter la statistique de test est celle de la loi normale centrée-réduite. Étant donné que sa fonction de répartition est basée sur la fonction erreur

, il conviendra de passer par la méthode analytique proposée par Abramowitz et Stegun et permettant une estimation fiable à

prés. Soit le changement de variable suivant,

La formule d’usage et faisant intervenir aussi bien que sa transformée

est,

Avec,

– ;

– ;

– ;

– ;

– .

Tendance pour le rejet de

En fonction de la taille d’échantillon, deux approches sont à considérer. Pour la plus simple (), il est trivial de voir que plus la valeur observée

s’éloigne de l’espérance plus on a de chance de rejeter

.

Pour celle un peu plus complexe (), soit

et donc la distribution est aléatoire ce qui implique le rejet de

. Soit

et alors on rejette

si,

–

–

Puisqu’une probabilité ne peut pas être négative, finalement la méthode consiste à comparer directement la probabilité ce qui se passe sur les queues de la distribution. Plus elles sont lourdes et moins on a de chances de rejeter .

Tendance lorsque

:

On s’intéresse désormais à la résistance du test binomial au fur et à mesure que la taille d’échantillon croît. Etant donné que la statistique de test suit une loi normale centrée-réduite, elle-même indépendante de , on cherchera à étudier la résistance de la formule de

directement. On travaille sur une répartition présentant pour chaque cellule les mêmes effectifs, que l’on multiplie selon la taille de l’échantillon et à laquelle on apporte une correction selon une loi uniforme dans

, soit un cas fictif correspondant à l’indépendance entre

et

. Le résultat attendu sera donc que quelque soit la taille de l’échantillon, l’on ne devrait pas rejeter l’hypothèse

d’inégalité des deux proportions. Le graphique ci-dessous montre l’évolution de la p-valeur

associée au test binomial lorsque

croît de

à

observations.

De manière hâtive, on reste en adéquation avec l’hypothèse de construction de la statistique de test binomial jusqu’à (

). En montant à

, on se forcera à rejeter

avec un risque assez fort compris entre

et

. Enfin, à

la p-valeur passe en dessous des

.

Cette simulation montre que le test binomial est assez robuste à la malédiction des grands échantillons.

Annexe théorique :

On présente ici la démonstration du calcul de l’espérance et de la variance de la loi Binomiale.

Dans un premier temps, il faut savoir que si suit une loi Binomiale de paramètres

alors la variable aléatoire peut être considérée comme la somme de

variables aléatoires

indépendantes et suivant une loi de Bernoulli de paramètre

. Cette dernière se caractérise par les éléments suivants,

et

Dès lors, on a,

Et,

Exemple :

Soit l’échantillon suivant,

Afin d’illustrer cet exemple, on réalise un diagramme en camembert :

On a et

. Il semblerait donc que

ne soit pas distribuée équitablement. On fixe alors

.

Donc,

Maintenant que l’on a la statistique de test, on souhaite déterminer la p-valeur. Comme alors on utilise l’approche par méthode de Monte-Carlo :

Or , donc on travaillera sur l’intervalle

. On a

,

D’où,

Enfin,

On en conclut que l’on ne peut pas rejeter et donc que les deux modalités ne sont pas distribuées selon la répartition de référence.

Application sous R :

Soit l’exemple suivant :

X = c(« A », »A », »A », »B », »B », »B », »B », »A », »A », »A », »A », »B », »B », »B », »B », »B », »B », »B », »B », »B »)

Package et fonction R : https://stat.ethz.ch/R-manual/R-devel/library/stats/html/binom.test.html

La fonction binom.test du package stats permet de lancer le test binomial afin de comparer la répartition des modalités de à la référence :

. On procède de la manière suivante :

binom.test(x = table(X), p = 0.5, alternative = « two.sided »)

Parmi les éléments à insérer les plus importants il faut relever :

– La variable que l’on souhaite étudier : ;

– La proportion de référence : ;

– La version bilatérale du test : .

On obtient les résultats suivants :

On vérifie :

– La proportion observée : « number of successes » ;

– La taille de l’échantillon : « number of trials » ;

– La p-valeur : « » , qui est la même que celle obtenue lors des calculs manuels (cf section « Exemple »).

Application sous SAS :

Soit l’exemple suivant :

data E;

input X $1.;

cards;

A

A

A

B

B

B

B

A

A

A

A

B

B

B

B

B

B

B

B

B

;

run;

Procédure SAS: http://support.sas.com/documentation/cdl/en/procstat/63104/HTML/default/procstat_freq_sect028.htm

La procédure FREQ permet de lancer le test binomial afin de comparer la répartition des modalités de à la référence :

. On procède de la manière suivante :

proc freq data = E;

tables X / binomial (equiv p = 0.5);

run;

Parmi les éléments à insérer les plus importants il faut relever :

– La variable que l’on souhaite croiser : tables X ;

– L’utilisation du test binomial : ;

– La proportion de référence :

.

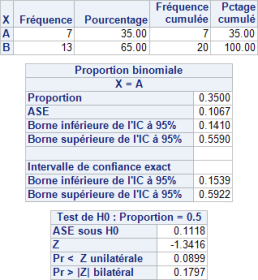

On obtient les résultats suivants :

On vérifie :

– Le premier tableau qui donne les effectifs par modalité de ;

– Dans le second tableau, on retrouve des éléments descriptifs dont la proportion observée ainsi que les intervalles de confiance ;

– Dans le troisième tableau, on retrouve la p-valeur bilatéral

qui diffère de celle obtenue lors des calculs manuels (cf section « Exemple ») du fait que SAS utilise quelque soit la taille de l’échantillon le z-score et la loi normale centrée-réduite, aboutissant cependant aux mêmes conclusions.

Bibliographie :

– Statistique. Dictionnaire encyclopédique de Yadolah Dodge ;

– The use of confidence or fiducial limits illustrated in the case of the binomial de C. J. Clopper et E. S. Pearson ;

– Goodness-of-fit statistics for discrete multivariate data de T. R. C. Read et N. A. C. Cressie.